随着企业和个人数据量的激增,如何高效管理与搜索文件资料,已成为提升工作效率的关键。

Coco AI 新增的 本地文件连接器,可以直接接入服务端文件系统,实现秒级搜索、即时访问,让服务器上的文件像本地文档一样触手可及。

本文将介绍如何通过 Docker 快速部署 Coco Server,并配置本地文件连接器,实现服务端文件的智能检索。

一、快速部署 Coco Server

Coco Server 是连接器功能的核心组件,部署完成后即可接入本地文件、RSS 等多种数据源。 生产环境建议使用持久化存储,避免数据丢失。

1. 推荐部署方式(生产环境)

docker run -d \

--name cocoserver \

-p 9000:9000 \

-v data:/app/easysearch/data \

-v config:/app/easysearch/config \

-v logs:/app/easysearch/logs \

infinilabs/coco:0.7.1-24262. 测试部署方式(非持久化)

docker run -d \

--name cocoserver \

-p 9000:9000 \

infinilabs/coco:0.7.1-2426建议生产环境使用持久化部署(第一种方式),测试环境可选择非持久化部署(第二种方式)。

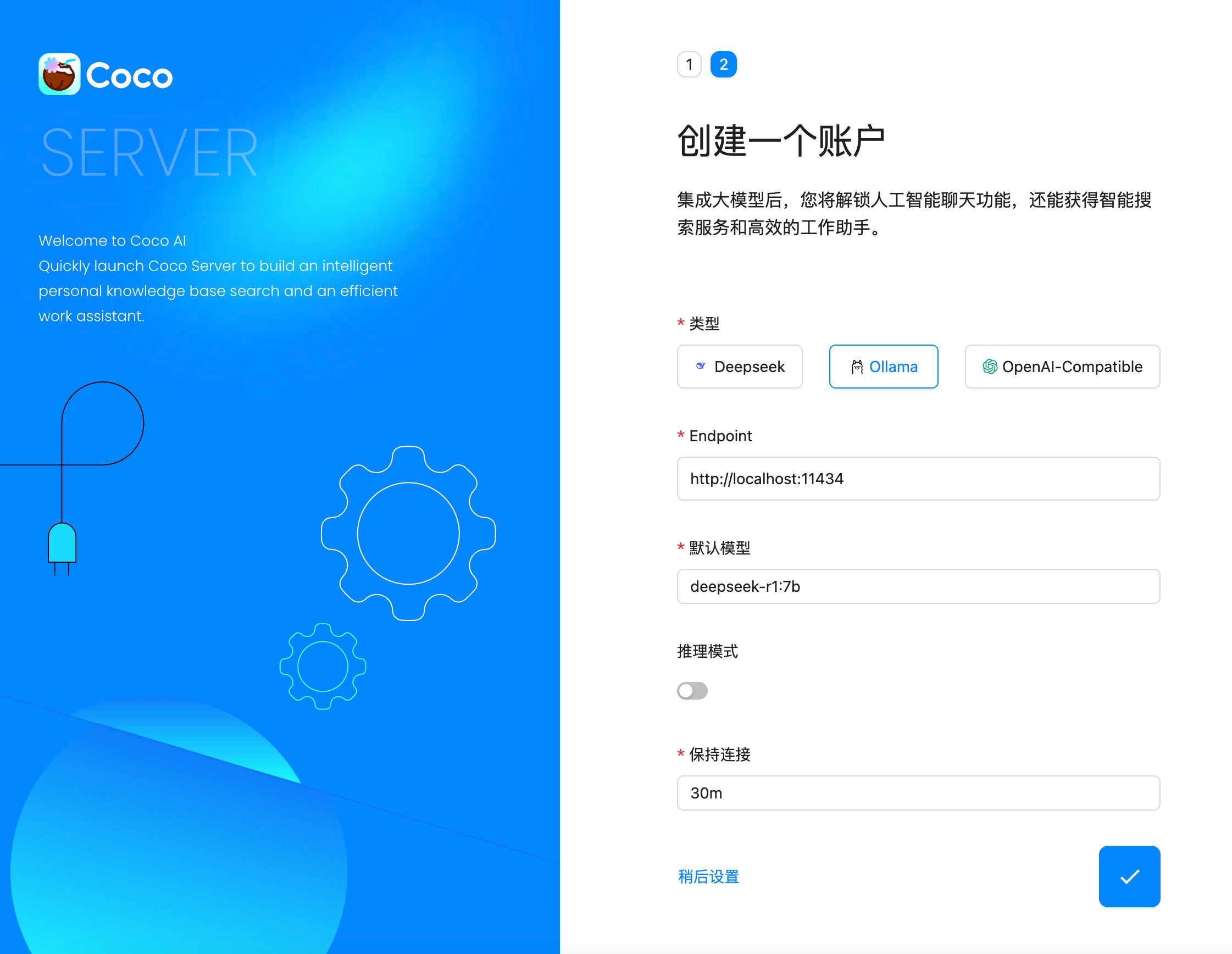

二、配置 AI 模型

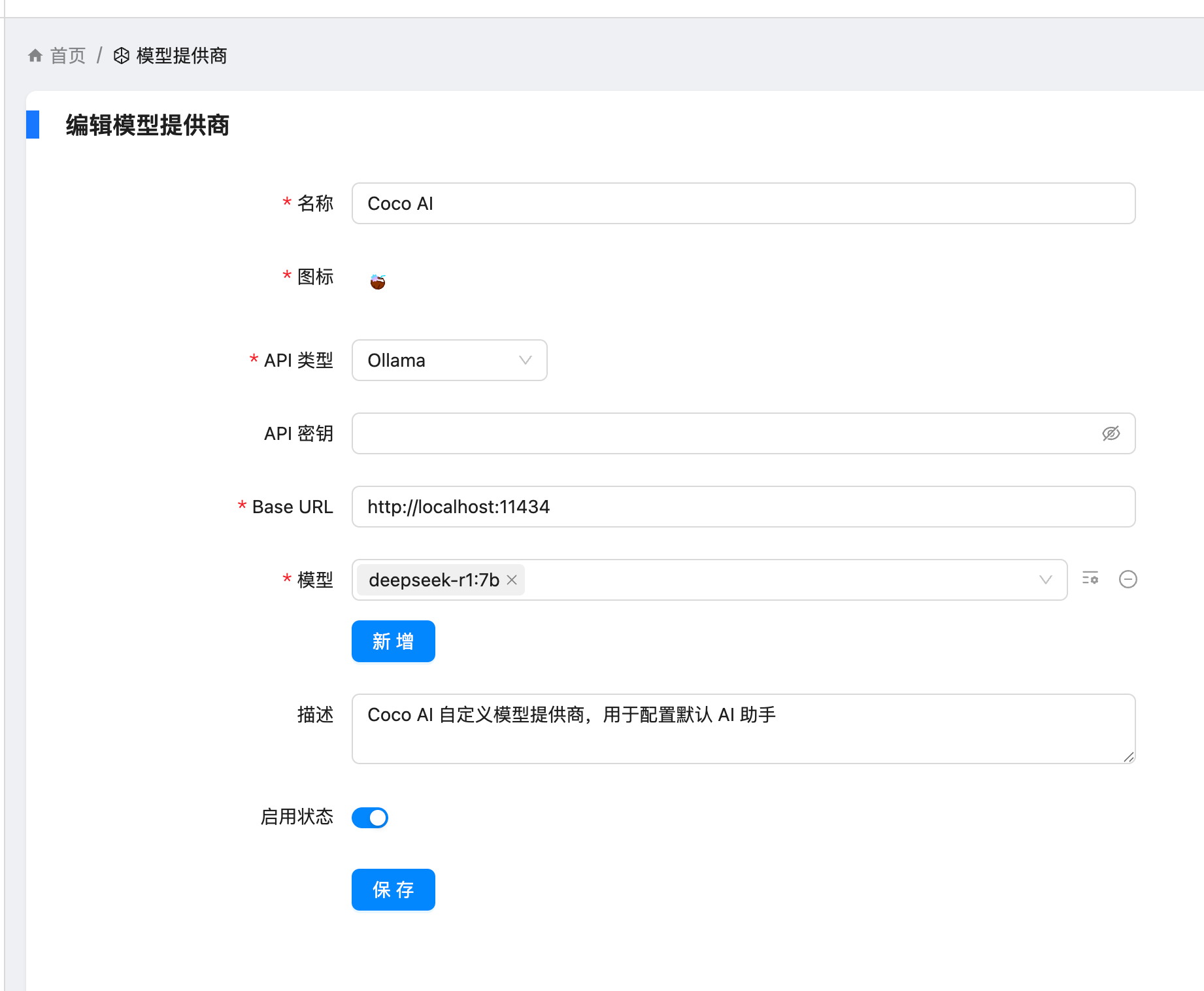

创建用户后,我选择 Ollama 作为模型提供商:

- 地址:

http://localhost:11434 - 模型:

deepseek-r1:7b

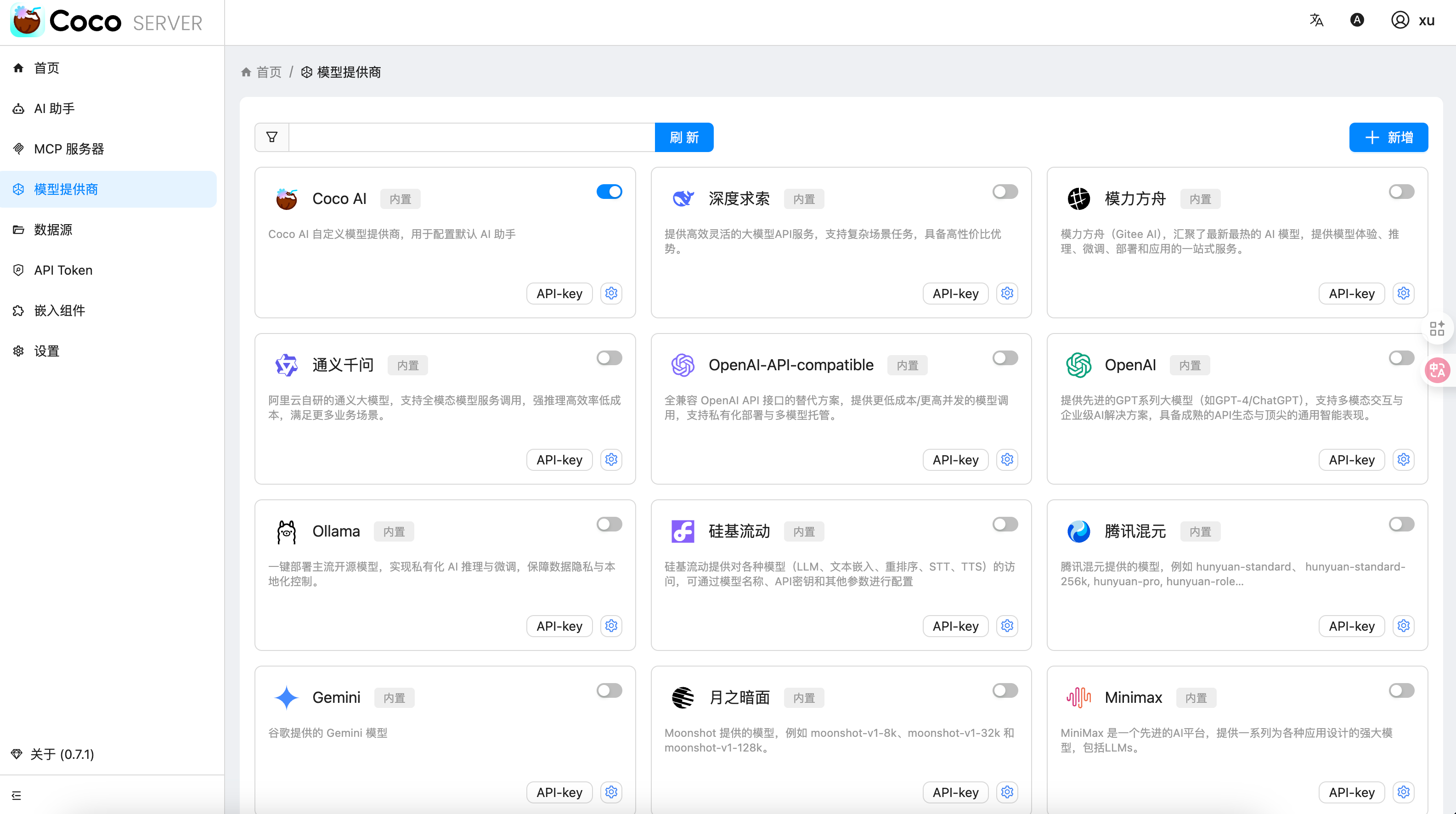

在「模型提供商」界面可以看到默认启用的 Coco AI,它会直接调用已配置的 Ollama,也支持任何兼容 OpenAI API 协议的 LLM。

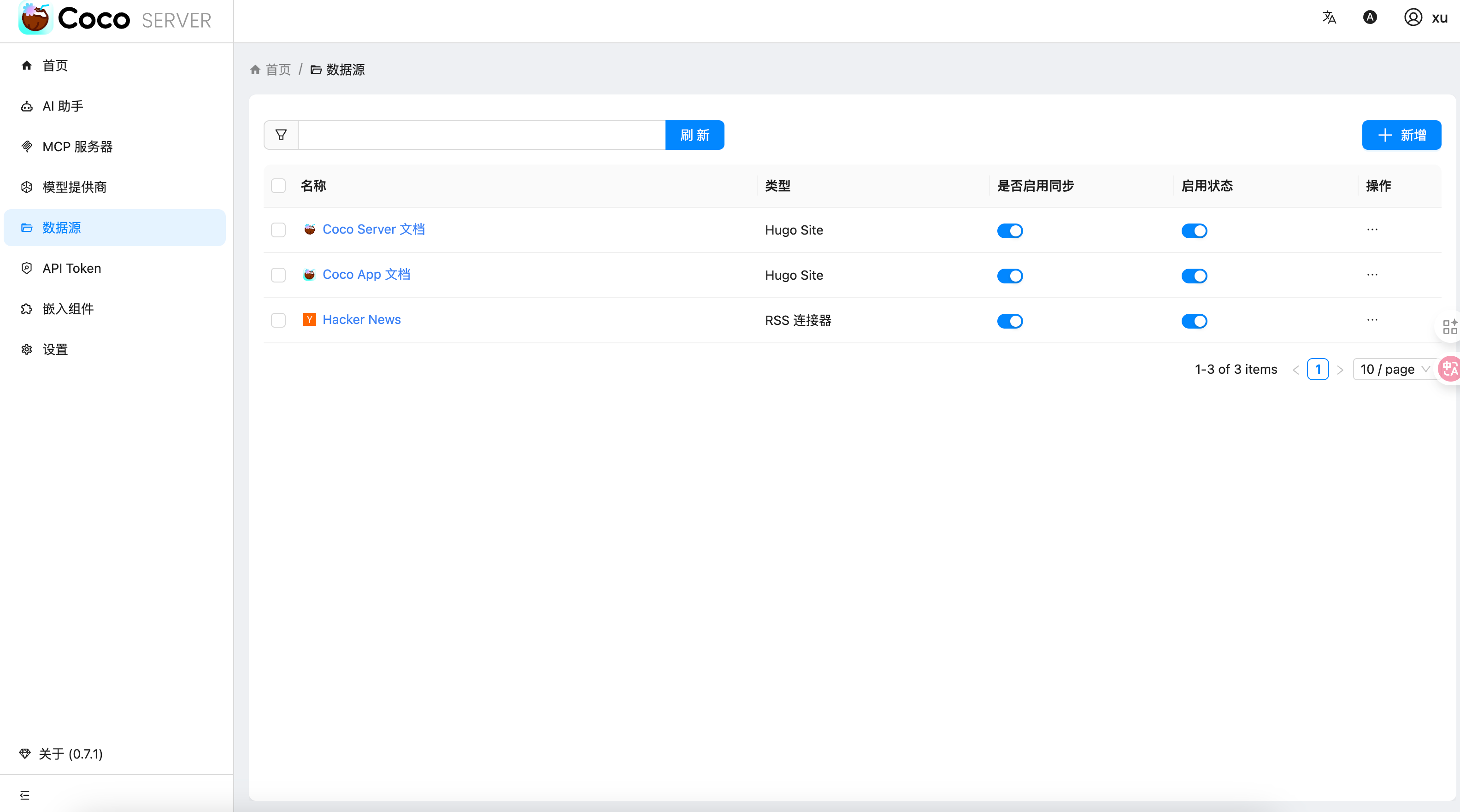

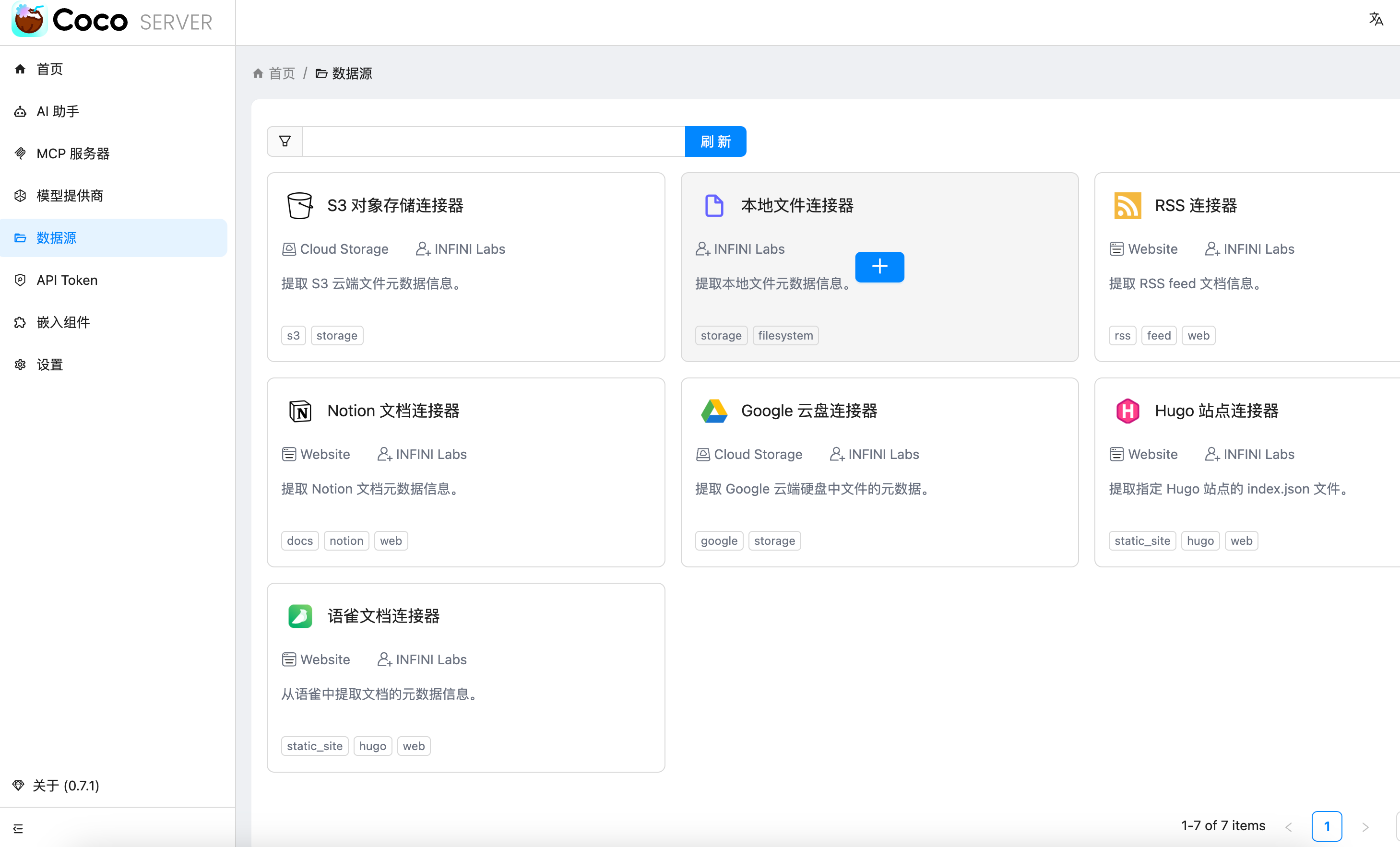

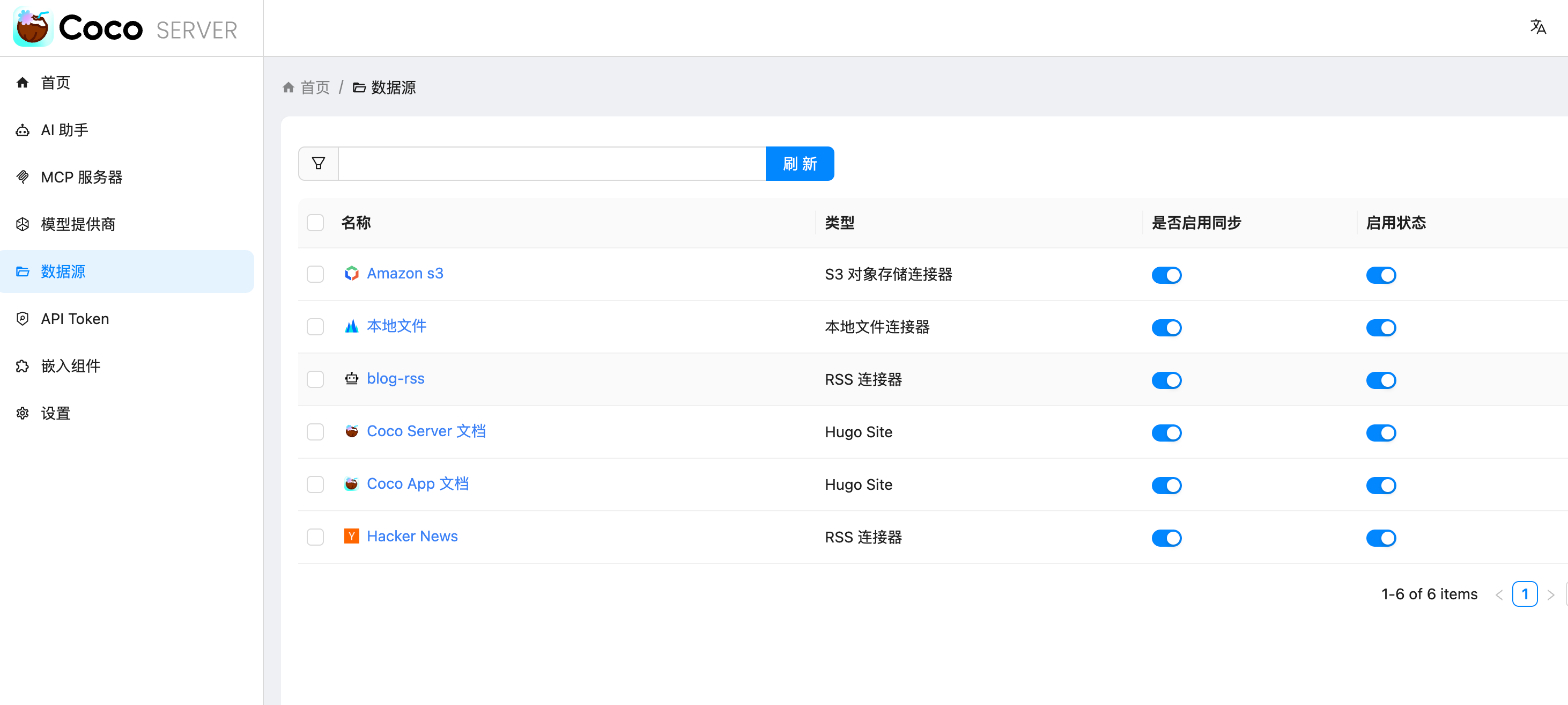

三、数据源概览

Coco AI 默认内置了 官方文档 和 Hacker News 数据源,并在近期新增:

- 本地文件连接器(本文重点)

- RSS 连接器

- S3 连接器

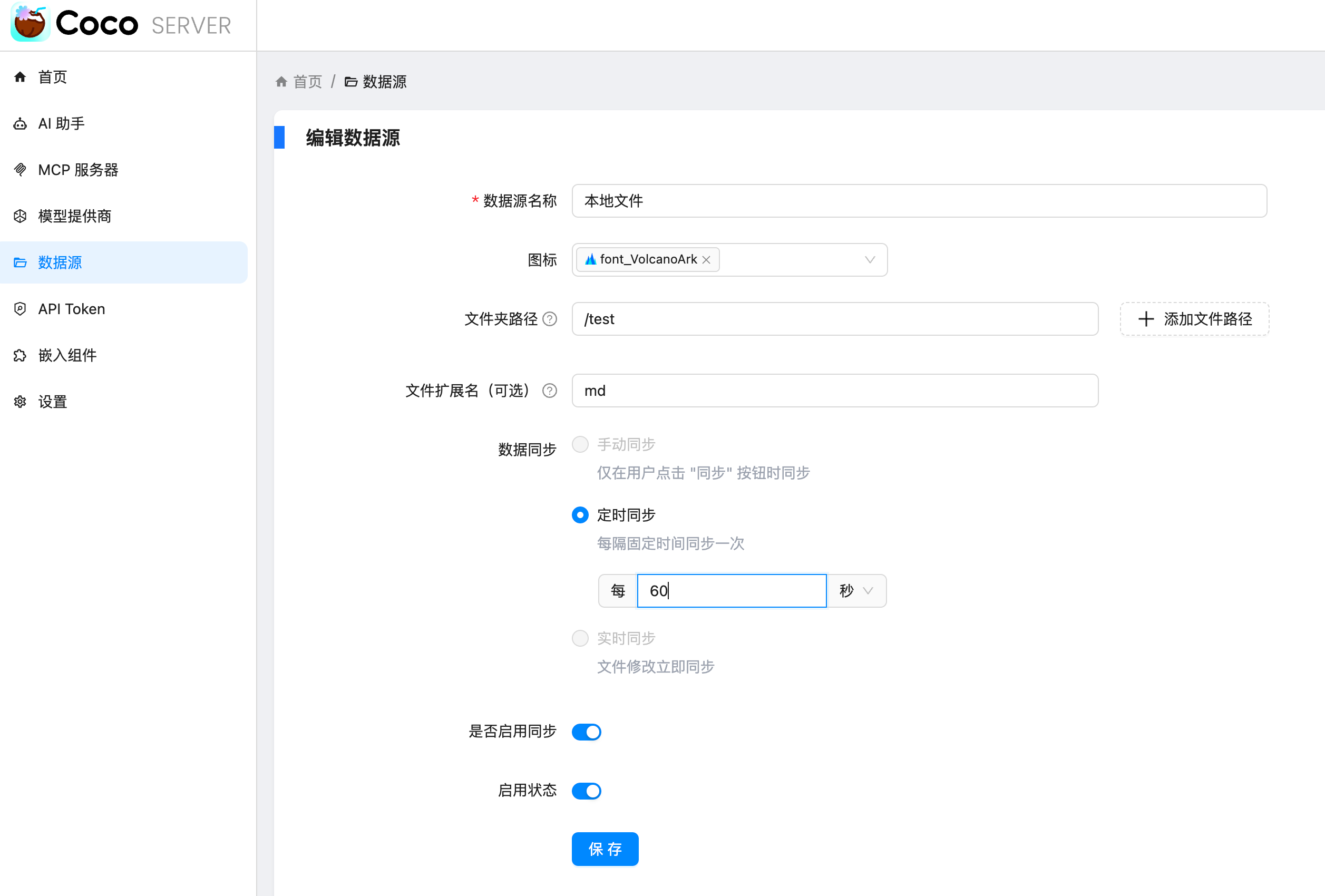

四、配置本地文件连接器

本地连接器的配置非常简单,只需:

- 选择文件路径

- 设置需要索引的文件后缀

- 等待系统从 localFS 中智能提取内容

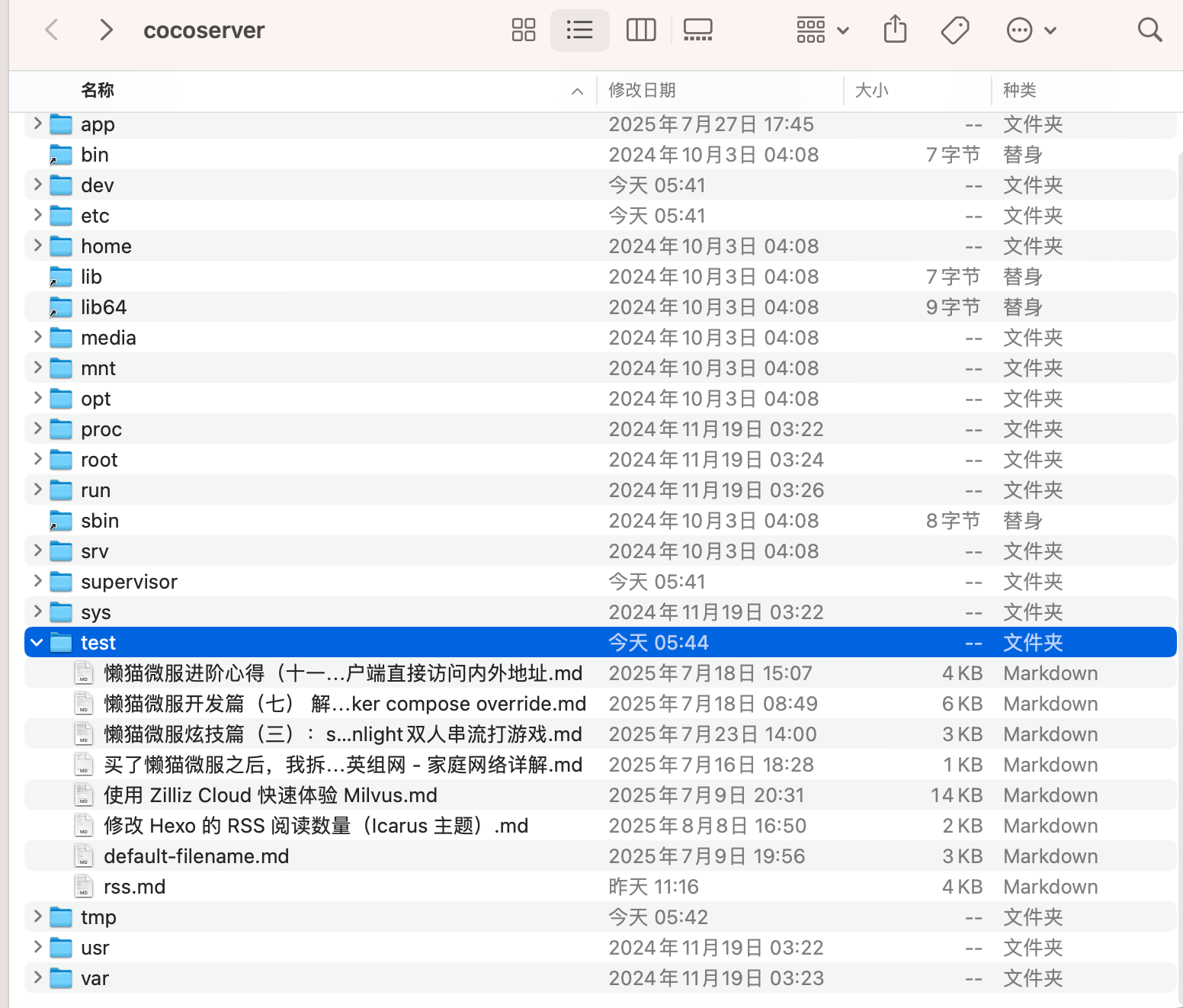

使用 Docker 时的注意事项

如果通过 Docker 部署 Coco Server,需要将本地目录映射到容器内,因为连接器读取的是容器内部路径,而非主机路径。

当然,也可以像我这样直接在 Orbstack 等容器平台上传文件,省去目录映射的步骤。

添加完成后,可以在连接器列表中看到新建的服务端本地文件连接器:

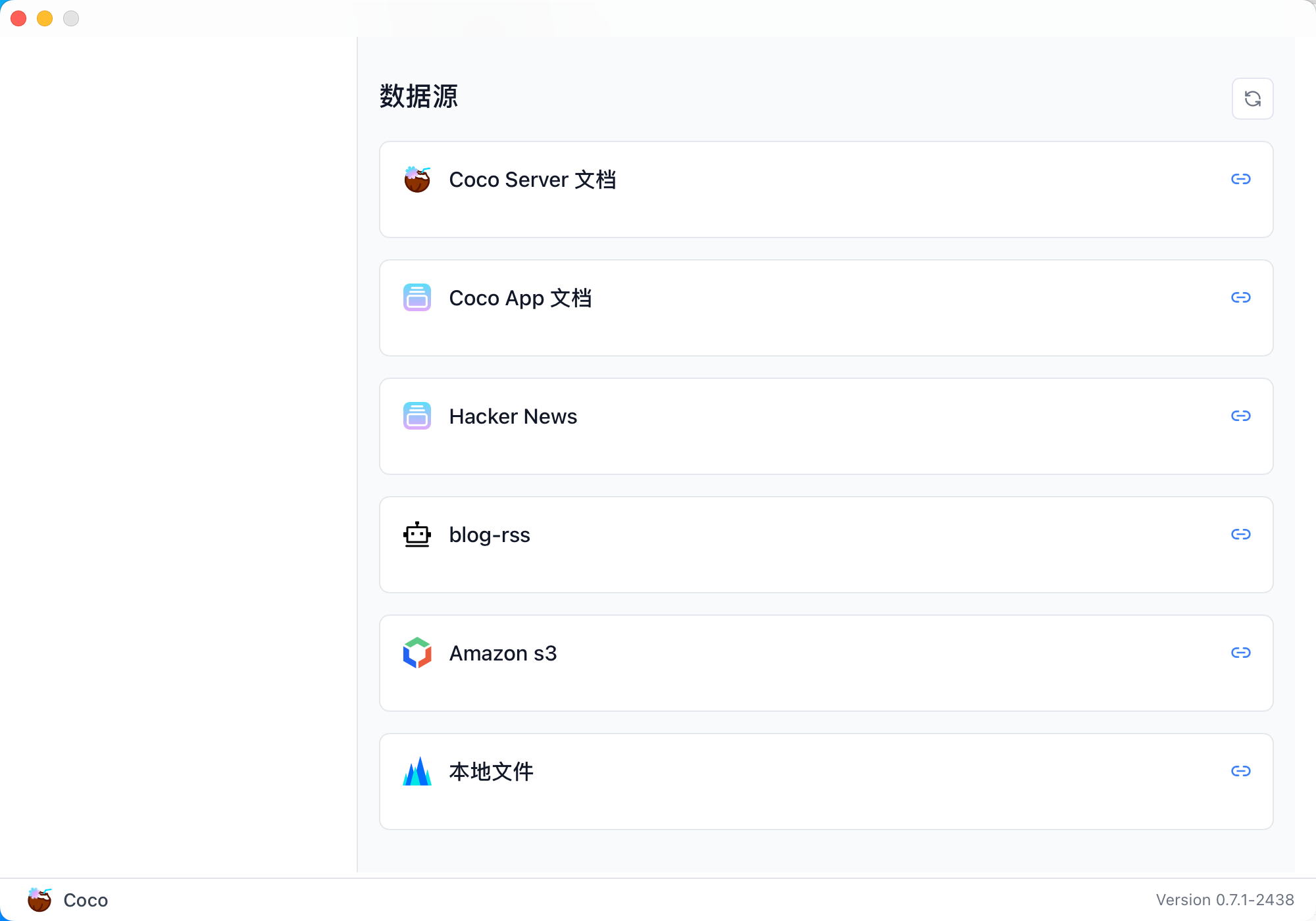

五、在 Coco App 中查看与检索

登录 Coco App 后,可以看到刚刚添加的 本地文件 数据源,并直接进行搜索。

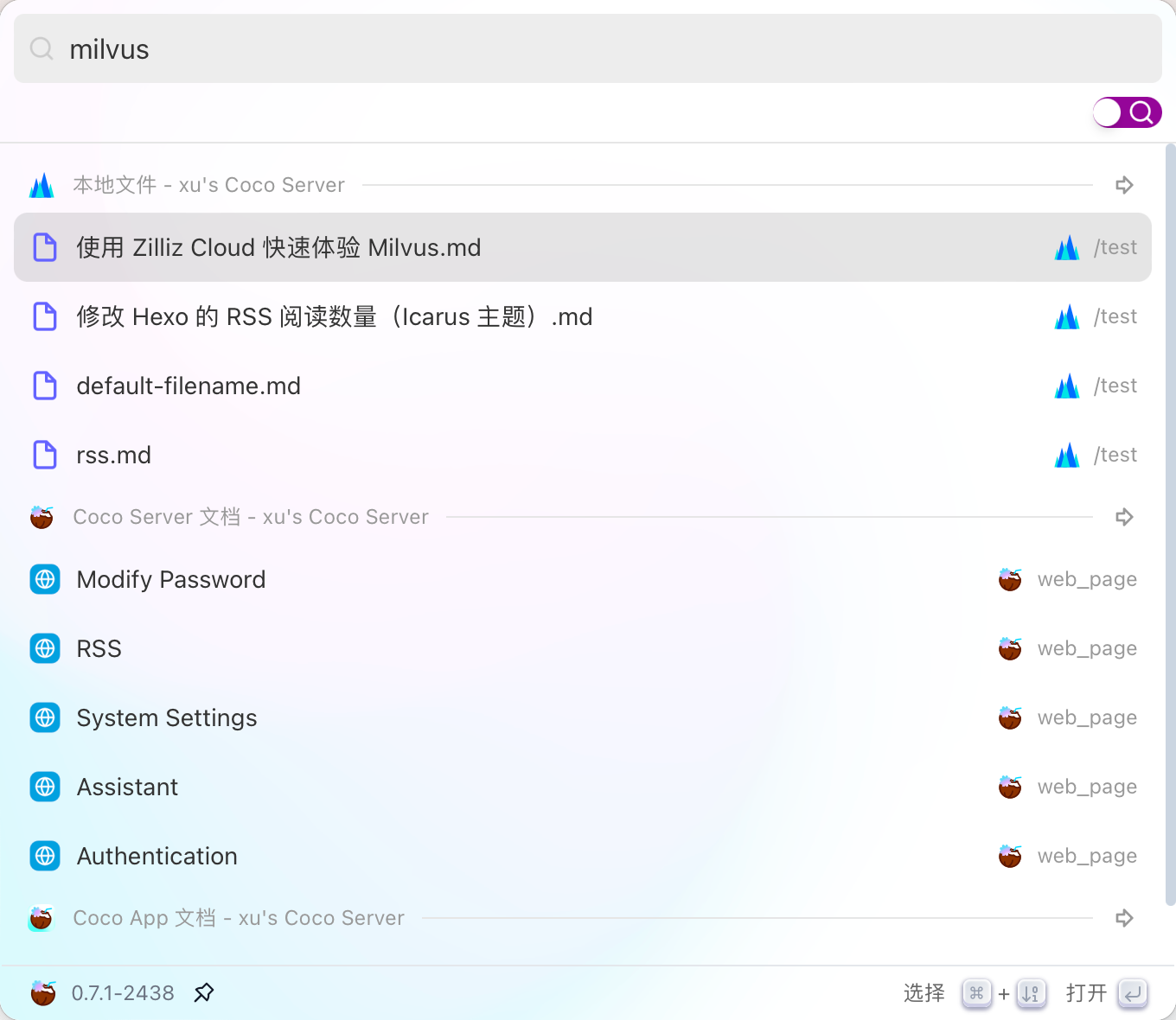

这是刚才添加的服务端文件的搜索结果:

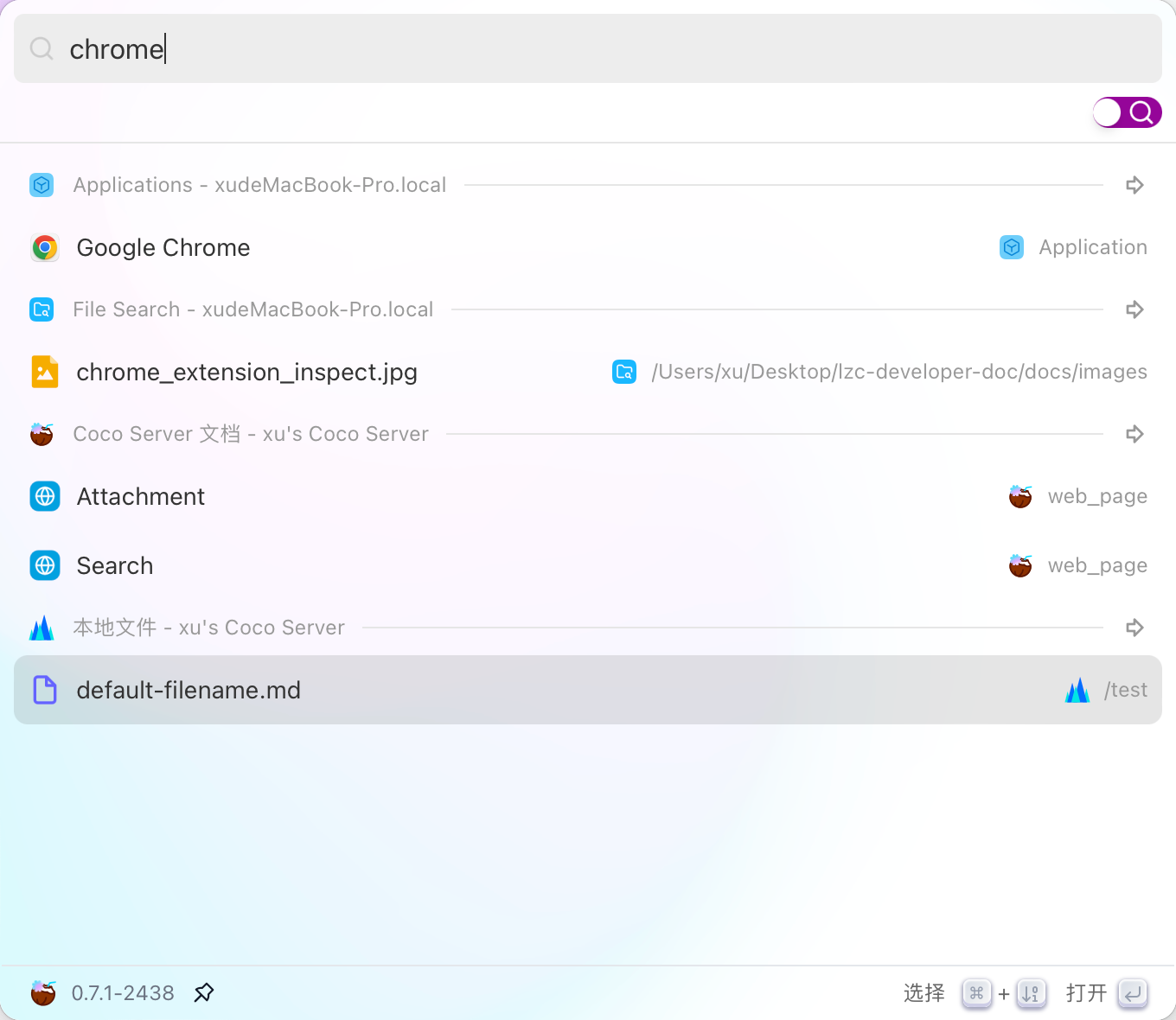

此外,Coco AI 还支持客户端本地文件搜索,但本文重点展示的是服务端文件检索功能:

结尾

通过本地文件连接器,Coco AI 不仅能帮助你把服务端的文档、日志、配置文件快速接入 AI 检索,还能结合多数据源进行统一搜索,大幅减少人工查找和信息碎片化的时间成本。

未来你还可以将 本地文件检索 与 RSS、API、数据库连接器组合使用,让企业级信息管理更智能、更实时、更高效。 如果你也想让服务器里的海量资料触手可及,不妨部署一个试试——也许你的检索方式,从今天就会不一样。